5 Ways, hogy távolítsa el az oldalt a keresési Yandex vagy google - devaka seo blog

Sok webmester előbb-utóbb szembe kell eltávolítani a kereső oldalakon, hogy került oda véletlenül, megszűnt a releváns kétágyas vagy tartalmaznak érzékeny ügyfél-információkat (az okok eltérőek lehetnek). A világos példa erre a már szenzációs helyzet Megafon, SMSes ahol az emberek vannak indexelve Yandex, a helyzet az online vásárlás, hol találja meg lehetett találni a személyes adatokat az ügyfelek és a részleteket a megrendelések, a helyzet a bankok és a közlekedési vállalatok, és így tovább ...

nem foglalkozik ebben a cikkben, az okok események ismertetett módon, és hogy hogyan lehet eltávolítani a felesleges Yandex vagy Google oldalán. A következmény az, hogy prenadlezhat webhelyén, különben meg kell felvenni a kapcsolatot a tulajdonos az ingatlan a megfelelő kérelmet.

5 módon, hogy távolítsa el oldalakat a keresési eredmények

1. 404-es hiba

HTTP / 1.1 404 Not Found

Ebben az esetben, akkor meg kell várni, amíg a robot újra nem jön erre az oldalra. Néha egy jelentős mennyiségű időt, attól függően, hogyan került be az indexbe.

Ha az oldal, amikor kiveszi a keresési léteznie kell az oldalon, ez a módszer nem alkalmas, akkor jobb, ha más az alábbiakban ismertetjük.

2. A robots.txt fájl

Egy nagyon népszerű módszer, hogy lezárja az indexelése egész szerkezet, vagy az egyes oldalak használata a gyökere a robots.txt fájlt. Van egy csomó útmutatók, hogyan kell beállítani ezt a fájlt. Itt bemutatunk néhány példát.

Bezár részén admin panel érintkezik az index a keresők:

User-Agent: *

Tiltása: / admin /

Zárja adott oldal indexelését:

User-Agent: *

Tiltása: /my_emails.html # záró my_emails.html oldal

Tiltása: /search.php?q=* # záró oldalán a keresési

Abban az esetben, robots.txt is meg kell várni az újbóli indexelés, míg a robot nem adja ki az index oldal, vagy egy egész szakasz. Ugyanakkor, bizonyos oldalakat maradhat az indexet, amennyiben az oka, hogy egyre több volt a külső linkek.

Ez a módszer használata kényelmetlen, ha szükséges, távolítsa el a különböző oldalakon a különböző szakaszok, ha lehetetlen, hogy dolgozzon ki egy közös sablon a tiltása irányelv robots.txt.

3. Meta-tag robotok

Ez egy alternatív módszer az előző, csak a szabály közvetlenül a HTML tag az oldalon, a címkék között

.Könnyű Meta tag, hogy felveheti a kívánt oldalt (a rendszer), ami nem kívánatos bejutását a kereső indexe, így a robots.txt fájl ugyanakkor egyszerű és egyértelmű. A hátránya ennek a módszernek, csak ebben a nehéz, hogy végre egy dinamikus weboldal sablon segítségével header.tpl, ha nincsenek speciális ismeretekkel.

4. címe X-Robots-Tag

Ezt a módszert alkalmazzák a külföldi kereső rendszerekben, például a Google, amely alternatívát kínál a korábbi módszerrel. A Yandex nem hivatalos információkat a támogatást a http-fejléc, de lehetőség van a közeljövőben lesz.

A lényege, hogy használata nagyon hasonlít egy robot meta tag, kivéve, hogy a rekord kell a http-fejlécek, amelyek nem láthatók az oldalon kódot.

X-Robots-Tag: NOINDEX, nofollow

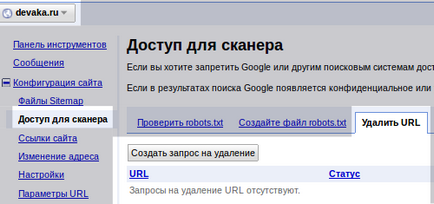

5. Kézi eltávolítása a panel webmester

Végül az utolsó és leggyorsabb módja annak, hogy távolítsa el a lapokat a névsor - ez az ő kézi eltávolítása.

Az egyetlen követelmény, hogy a kézi eltávolítása oldalak - alá kell tartozniuk a robot korábbi eljárások (a robots.txt, meta tag, vagy 404-es hiba). Azt vette észre, hogy a Google kezeli a kérelmeket eltávolítására néhány órán belül, Yandex kell várni a következő frissítés. Használja ezt a módszert, ha sürgősen el kell távolítania egy kis oldalak számát a keresést.

kapcsolódó linkek

5 tipp kidolgozott gyakorlati 404 oldal

Javítani használhatósága 404. oldalakon csökkenti a visszafordulási arány. A cikk egy pár tipp, hogy a 404. oldalon hatékonyabb.

Minden információ a robots.txt

Azok számára, akik még nem szembesült konfigurálása robots.txt fájlt, az erőforrás hasznos kiindulási pont. Az összegyűjtött sok példát és egyéb hasznos információkat.

Yandex: A robots.txt

Hivatalos példák a robots.txt fájlt Yandex. Is, ott kerülnek bemutatásra Yandex elszámolni iránymutatásokat és egyéb tanácsot.

Meta tag Google tiszteletben tartja és Yandex tűnik koncentrálni nem látni. Csak tegnap észrevette, hogy Yandex keresési adagolunk kétszer több oldalt, mint vannak a helyszínen. Kiderült, hogy figyelmen kívül hagyta ,és a tag felhő van az index.

A Google azt mondja (és az én kis tapasztalat megerősíti), hogy ő csak nem index két esetben:

1) Meta tag

2) robots.txt + url bejegyzést a listából eltávolítani webmasters.google (Configuration -> Access Scanner -> Törlés URL)

És eltávolítjuk nagyon könnyen. A Google néhány órán belül, de mindig tartja a története az URL-t. Yandex ... csak ezt a cikket rájöttem, hogy miért lehetetlen volt eltávolítani - meg kell várni egy pár év, amikor rájött, mit kell tennie.

És, hogy mennyire hatékonyan záró oldalak indexelése metacímkézési robotok, míg nem írt ilyen tiltó irányelvet a robots.txt fájlt? Elvégre, ha fordított a helyzet: a robots.txt fájlban oldal zárva van, akkor a meta tag robotok figyelmen kívül hagyja a SS.

natkalin. Igen, a robotok ez csak egy ajánlás, hogy a kereső, de nem egy utasítás cselekedni, ahogy azt mondta egyszer Mett Katts. Azonban robotok kövesse azokat gondosan, ha éppen ellenkezőleg van egy nyomós oka. A meta-tag, kapok hagyni, hogy az oldalak a Yandex. Voltak körülbelül 400, 5-7 frissítések 58 volt, nagyon sokáig, mert a robot nem jön gyakran az oldalakon, de a meta tag még fut ...

WMAs. Ha törli egy linket egy oldalra, a keresők nem hiba bejelentéséhez. Míg igen, egy ideig fognak unatkozni 🙂

A panel a Google webmaster Az oldal eltávolítjuk egyenként?) Ha mondjuk, van egy hely, ahol nyelvi változatok terveztünk a tervezés, melyeket nem fordította, és később nem a fordítás nekik. Kiderült, egy csomó oldalt átjátszás)) is, persze, zárja be őket indexelés később, de ezek az oldalak továbbra is az index még egy pár hónap, és hogyan kell másolni az oldal nem kívánatos. A kérdés az, van-e lehetőség, hogy távolítsa el az összes panelt egy adott nyelvi változatban az oldal, vagy kell még, hogy lassan vegye egy oldalon?) Köszönöm)

Engedjék meg, hogy tisztázza. Talán valaki segít időt takaríthat meg. Ha van egy robots.txt irányelvek 2 'User-agent: Yandex' és a 'User-Agent:' Yandex keresi csak a saját rész, figyelmen kívül hagyva az általános. Ezért minden tiltása: helyezze részben Yandex vagy törölni ezt a részt, és használja az irányelv „minden robottal. Tennem, mielőtt jött, megölt egy félórás 🙂

Azonnali, bevetetlen helyén, amely már tele a tárhely, a csoda volt az index, 145 oldal, ezek az oldalak üres vagy görbe a szöveget, vagy egy rip-off, de tele volt a célja, hogy megváltoztassa.

Hogyan lehet ebben a helyzetben? Kell távolítsa el az összes oldalak index? Vagy, akkor gyorsan erősít a főoldalon? Átnevezése sok oldalt, hogy mi fog történni, hogy a régi oldalak vannak indexelve? És ezt a szemetet az index, hatással lesz az értékelés egy későbbi optimalizálás?

Én is nagyon hálás egyértelmű választ!

Ha én a helyedben zárt indexelési helyén robots.txt és teljesen eltávolítani az indexből a panel webmesterek. Megjelenése után minden már nyitva és indexelés megint.

Nem szankciókat nem kell semmilyen esetben Ön által kiválasztott. És amikor arról beszélünk, rangsorolás, értjük a minősítés hasznos dokumentumot, csak szemetet nem jelenik meg.

Törlöm a profilt a helyén, de a személyes információkat, mint például név, születési dátum, fénykép még mindig látható a Google-keresés. Lehetséges ebben az esetben hozzon létre egy 404, ha nem a saját honlapján? El kell távolítani az információt valamilyen módon, de nem tudom, hogyan. Már elment egy Google szolgáltatást, én meséltem a problémát. Azt mondták, hogy meg kell hivatkozni a terület tulajdonosának / rendszergazda. Küldtem egy csomó levelet, de a csendet.

Catherine az információ egy klónozó funkció, amely tiszta, akkor nem mindig. Ha nincs az adott helyeket, ahol a törölni kívánt információkat, nem valószínű, hogy van valami munka, meg kell tárgyalni a tulajdonosok. Vagy ha valahogy megsérti a törvényt, hogy írjon egy panaszt a gazda. 404 valaki másnak a weboldalról lehet nem csak az admin.

Peter, akkor valószínűleg egy véletlen egybeesés. Máshol elcseszte. Ellenőrizze robots.txt, meta-robotok és a HTTP-fejléceket.

meta-robotok ellenőrzik - minden jó, http fejlécek - is jó.

Sőt, amikor elvitték a helyszínen, a robots.txt fájl nem Yandex irányelvet. Megvan hozzá, hogy ellenőrizze a rendelkezésre álló oldalak, mindenekelőtt megfelelően hajtják végre.

Lehetséges: Yandex fűrész felújított robotok, és úgy döntött, hogy úgy mondjam, a nulláról kell kezdeni?